正在查看初级爬虫工程师严谨简历模板文字版

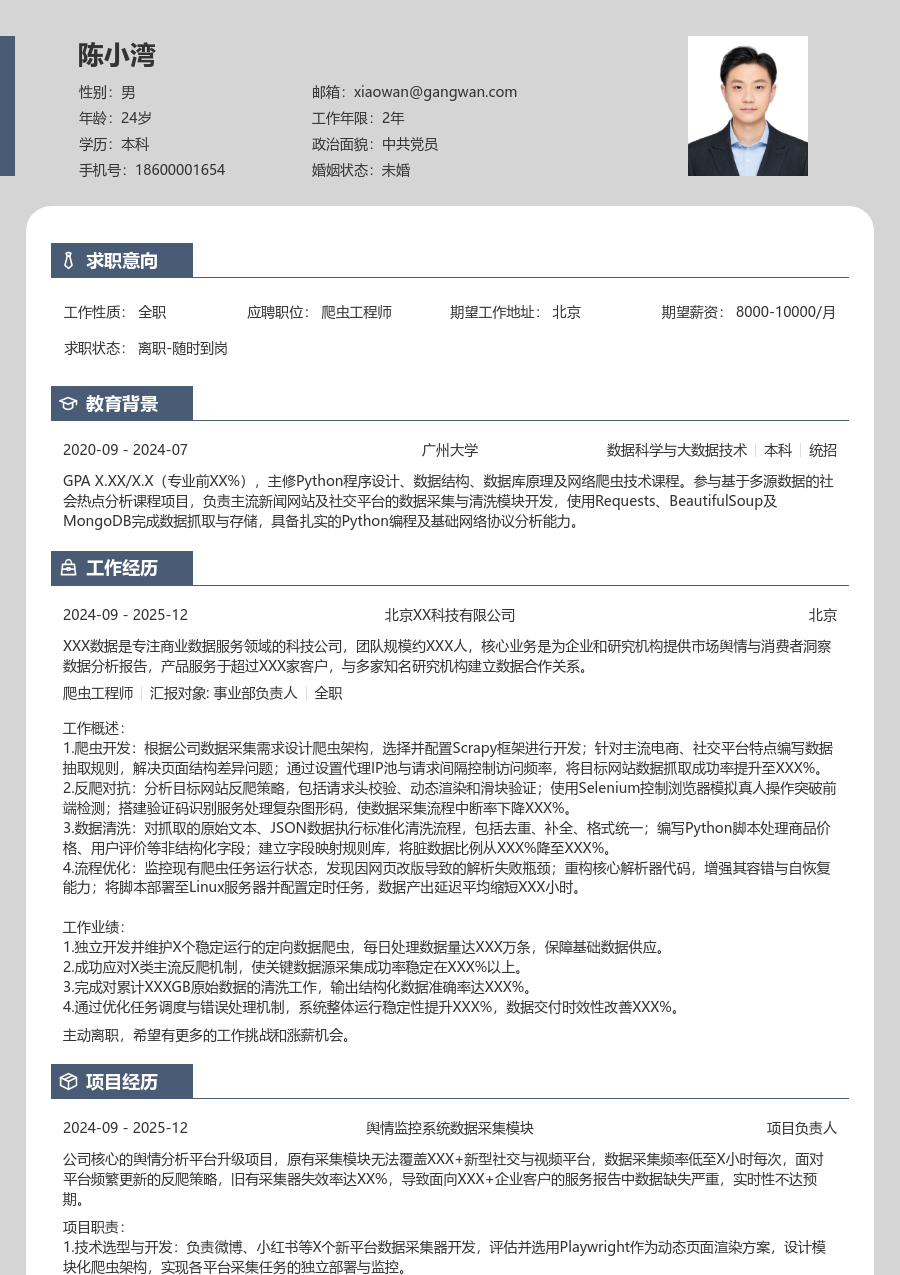

陈小湾

求职意向

工作经历

XXX数据科技是一家专注于网络公开数据采集与治理服务的科技公司,团队规模约XXX人,核心业务是为企业客户及研究机构提供定制化的数据采集、清洗与分析解决方案,产品服务于超过XXX家客户,在电商、舆情等多个垂直领域建立了数据服务能力。

工作概述:

1.数据采集:根据业务需求分析目标网站结构与数据字段,编写Python爬虫脚本,使用Requests/Scrapy框架模拟请求并解析HTML/JSON响应;配置代理IP池应对访问限制,通过异常重试与日志记录保障任务完成率;每日监控数据产出,调整采集策略与频率,将核心数据采集成功率提升至XXX%,采集效率提升XXX%。

2.反爬应对:针对网站封禁IP、验证码等反爬机制,研究并部署动态IP代理、请求头随机化、验证码识别服务等应对方案;维护Cookie池模拟用户会话,优化请求间隔与并发控制参数;通过模拟浏览器行为的Selenium解决动态加载内容,使得目标网站数据可采率稳定在XXX%以上,人工干预需求减少XXX%。

3.数据清洗:对采集到的原始数据进行标准化处理,制定去重、字段格式化、异常值过滤的清洗规则;使用Pandas库进行数据转换与初步校验,输出结构化的CSV或数据库文件;定期复盘数据质量,与业务方核对数据口径,确保下游使用的数据可用性达到XXX%,无效数据存储成本降低XXX%。

4.任务调度:使用APScheduler或Celery构建爬虫任务的自动化调度系统,设定定时或触发式执行任务;监控任务执行状态与资源占用,编写告警脚本通知异常;优化任务队列与依赖关系,实现XXX个核心数据源的稳定自动化采集,任务准时执行率超过XXX%,释放人力XXX%。

5.监控维护:建立爬虫健康度监控体系,通过关键指标如响应成功率、数据量波动、代理IP有效性进行日常巡检;定期检查目标网站结构变化,及时更新解析规则(XPath/CSS Selector);维护爬虫代码库与依赖环境,修复运行中出现的超时、解析失败等问题,将故障平均发现与修复时间缩短XXX%,系统整体可用性维持在XXX%。

6.文档沉淀:撰写爬虫项目技术文档,清晰记录目标网站、采集逻辑、反爬策略、字段说明与运行部署步骤;编写数据清洗规则文档,便于团队协作与后续维护;通过文档管理,使得新人接手同类爬虫项目的平均上手时间缩短XXX%,团队内技术沟通成本降低XXX%。

工作业绩:

1.独立负责并维护超过XXX个核心数据源的采集任务,累计稳定产出结构化数据超XXXTB,支撑公司XXX个数据产品的原料供应。

2.有效应对各类反爬策略,将核心数据源采集稳定性从XXX%提升至XXX%,保障了数据交付的及时性与连续性。

3.建立标准化的数据清洗流程与规则库,将下游数据投诉率降低XXX%,数据直接可用率提升至XXX%。

4.搭建并优化爬虫任务调度与监控体系,实现XXX%的日常采集任务自动化,释放约XXX人/天的重复性工作量。

主动离职,希望有更多的工作挑战和涨薪机会。

项目经历

公司为零售客户提供的核心数据服务项目,需对主流电商平台超过XXX个品牌、日均XXX万SKU的商品价格与促销信息进行每日监控。原有个别脚本采集方式存在效率低、易被封禁、数据不完整等问题,无法满足客户对数据及时性与准确性的要求,在促销季数据缺失率高达XXX%,导致客户决策延迟。

项目职责:

1.爬虫开发:负责京东、天猫等核心平台价格爬虫的编码与优化,使用Scrapy-Redis框架搭建分布式爬虫集群,通过动态IP代理与请求头管理绕过基础反爬。

2.反爬破解:分析目标平台Ajax接口与登录验证逻辑,模拟完整用户行为链获取数据;集成第三方打码平台处理复杂验证码,将登录成功率维持在XXX%以上。

3.数据解析:针对不同平台页面结构设计差异化的解析规则,使用XPath与正则表达式精准提取价格、库存、促销标签等信息,并处理动态渲染内容。

4.系统维护:编写监控脚本,实时报警采集异常;定期巡检并更新因网站改版而失效的解析规则,确保系统日均稳定运行超过XXX小时。

项目业绩:

1.系统上线后,目标SKU的日采集完整率从XXX%提升至XXX%,数据更新频率从24小时缩短至4小时内。

2.通过分布式架构与反爬策略优化,单个电商平台的数据采集效率提升XXX%,服务器资源成本下降XXX%。

3.该项目支撑了公司超过XXX家付费客户的价格监控需求,客户满意度评分提升至

X.X/

5.0,直接贡献年度营收增长约XXX万元。

教育背景

GPA X.XX/X.X(专业前XXX%),主修Python程序设计、数据结构、数据库原理等核心课程,参与校园新闻聚合系统课程设计,在团队中负责网络爬虫模块开发,使用Requests+BeautifulSoup完成对XXX个新闻站点的数据采集与入库,熟悉Linux基础命令及Git版本控制工具。

自我评价

培训经历

系统学习了数据分析全流程方法论,并将数据采集与清洗环节的知识应用于实际工作,优化了数据质量校验逻辑,提升了后续分析数据的可用性与准确性,输出的数据采集规范文档成为团队参考标准。

初级爬虫工程师严谨简历模板

适用人群: #爬虫工程师 #初级[1-3年]

关于爬虫工程师简历的常见问题

[基本信息]

姓名:陈小湾

性别:男

年龄:26

学历:本科

婚姻:未婚

年限:4年

面貌:党员

邮箱:xiaowan@gangwan.com

电话:18600001654

[求职意向]

工作性质:全职

应聘职位:爬虫工程师

期望城市:北京

期望薪资:8000-10000

求职状态:离职-随时到岗

[工作经历]

北京XX科技有限公司 | 爬虫工程师

2024-09 - 2025-12

XXX数据科技是一家专注于网络公开数据采集与治理服务的科技公司,团队规模约XXX人,核心业务是为企业客户及研究机构提供定制化的数据采集、清洗与分析解决方案,产品服务于超过XXX家客户,在电商、舆情等多个垂直领域建立了数据服务能力。

工作概述:

1.数据采集:根据业务需求分析目标网站结构与数据字段,编写Python爬虫脚本,使用Requests/Scrapy框架模拟请求并解析HTML/JSON响应;配置代理IP池应对访问限制,通过异常重试与日志记录保障任务完成率;每日监控数据产出,调整采集策略与频率,将核心数据采集成功率提升至XXX%,采集效率提升XXX%。

2.反爬应对:针对网站封禁IP、验证码等反爬机制,研究并部署动态IP代理、请求头随机化、验证码识别服务等应对方案;维护Cookie池模拟用户会话,优化请求间隔与并发控制参数;通过模拟浏览器行为的Selenium解决动态加载内容,使得目标网站数据可采率稳定在XXX%以上,人工干预需求减少XXX%。

3.数据清洗:对采集到的原始数据进行标准化处理,制定去重、字段格式化、异常值过滤的清洗规则;使用Pandas库进行数据转换与初步校验,输出结构化的CSV或数据库文件;定期复盘数据质量,与业务方核对数据口径,确保下游使用的数据可用性达到XXX%,无效数据存储成本降低XXX%。

4.任务调度:使用APScheduler或Celery构建爬虫任务的自动化调度系统,设定定时或触发式执行任务;监控任务执行状态与资源占用,编写告警脚本通知异常;优化任务队列与依赖关系,实现XXX个核心数据源的稳定自动化采集,任务准时执行率超过XXX%,释放人力XXX%。

5.监控维护:建立爬虫健康度监控体系,通过关键指标如响应成功率、数据量波动、代理IP有效性进行日常巡检;定期检查目标网站结构变化,及时更新解析规则(XPath/CSS Selector);维护爬虫代码库与依赖环境,修复运行中出现的超时、解析失败等问题,将故障平均发现与修复时间缩短XXX%,系统整体可用性维持在XXX%。

6.文档沉淀:撰写爬虫项目技术文档,清晰记录目标网站、采集逻辑、反爬策略、字段说明与运行部署步骤;编写数据清洗规则文档,便于团队协作与后续维护;通过文档管理,使得新人接手同类爬虫项目的平均上手时间缩短XXX%,团队内技术沟通成本降低XXX%。

工作业绩:

1.独立负责并维护超过XXX个核心数据源的采集任务,累计稳定产出结构化数据超XXXTB,支撑公司XXX个数据产品的原料供应。

2.有效应对各类反爬策略,将核心数据源采集稳定性从XXX%提升至XXX%,保障了数据交付的及时性与连续性。

3.建立标准化的数据清洗流程与规则库,将下游数据投诉率降低XXX%,数据直接可用率提升至XXX%。

4.搭建并优化爬虫任务调度与监控体系,实现XXX%的日常采集任务自动化,释放约XXX人/天的重复性工作量。

[项目经历]

项目名称:电商价格监控系统

担任角色:项目负责人

公司为零售客户提供的核心数据服务项目,需对主流电商平台超过XXX个品牌、日均XXX万SKU的商品价格与促销信息进行每日监控。原有个别脚本采集方式存在效率低、易被封禁、数据不完整等问题,无法满足客户对数据及时性与准确性的要求,在促销季数据缺失率高达XXX%,导致客户决策延迟。

项目业绩:

1.系统上线后,目标SKU的日采集完整率从XXX%提升至XXX%,数据更新频率从24小时缩短至4小时内。

2.通过分布式架构与反爬策略优化,单个电商平台的数据采集效率提升XXX%,服务器资源成本下降XXX%。

3.该项目支撑了公司超过XXX家付费客户的价格监控需求,客户满意度评分提升至

X.X/

5.0,直接贡献年度营收增长约XXX万元。

[教育背景]

杭州电子科技大学

数据科学与大数据技术 | 本科

GPA X.XX/X.X(专业前XXX%),主修Python程序设计、数据结构、数据库原理等核心课程,参与校园新闻聚合系统课程设计,在团队中负责网络爬虫模块开发,使用Requests+BeautifulSoup完成对XXX个新闻站点的数据采集与入库,熟悉Linux基础命令及Git版本控制工具。