正在查看中级数据采集整洁简历模板文字版

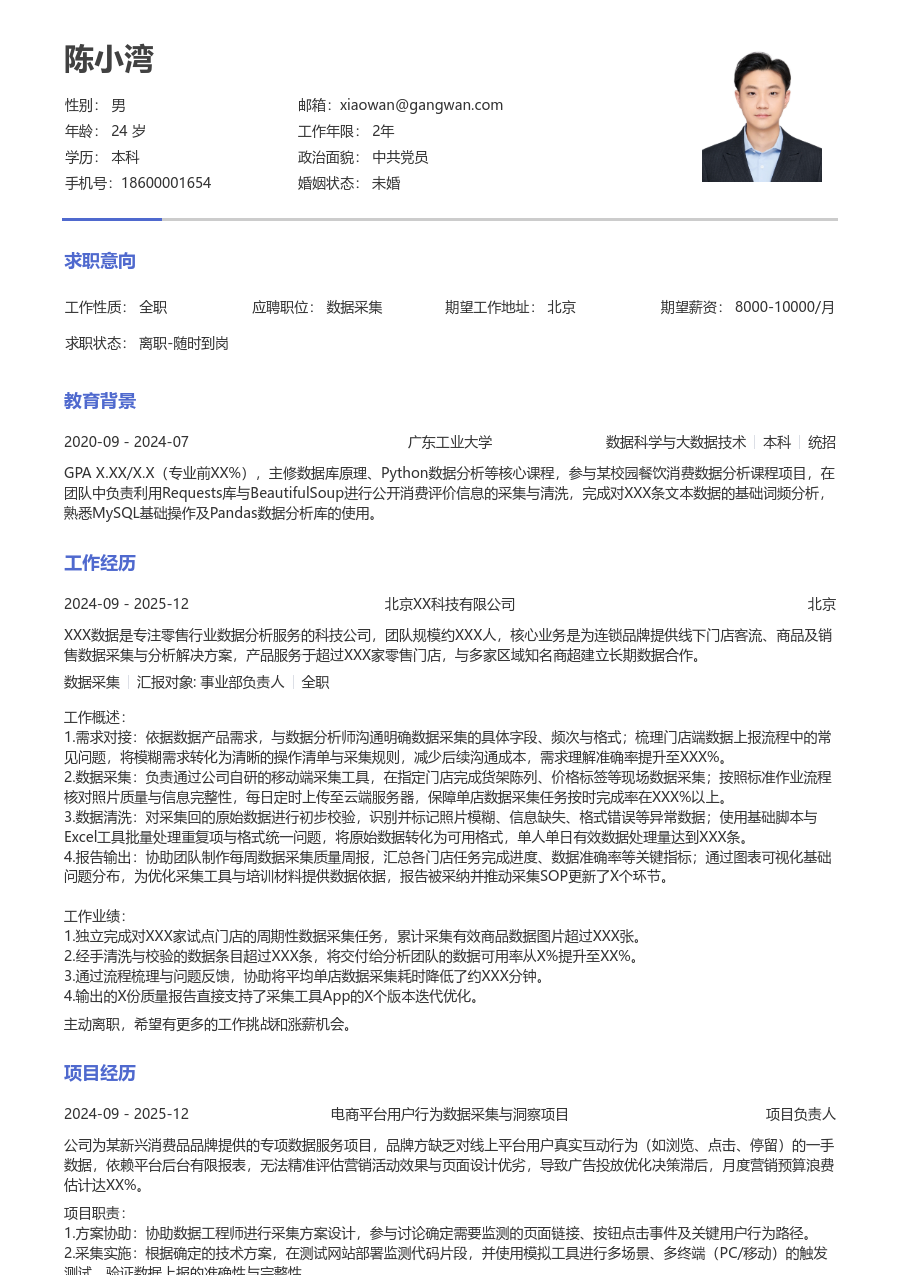

陈小湾

求职意向

工作经历

XXX数据科技是一家专注于为金融和零售行业提供数据服务与解决方案的公司,团队规模约XXX人,核心业务是整合多渠道商业数据,为客户提供市场洞察与决策支持,服务超过XXX家机构客户,与多家数据供应商建立稳定合作。

工作概述:

1.数据源寻源:针对客户对电商评论数据的需求,主动寻找和评估潜在数据供应商;通过技术验证与商务谈判,确定数据质量与价格;主导引入X家新供应商,丰富了数据来源渠道,将单一数据源依赖度降低了XXX%。

2.爬虫脚本开发:依据数据采集需求,使用Python编写和维护定向爬虫脚本;处理目标网站的反爬策略,如验证码识别与动态IP代理池管理;优化请求频率与数据解析逻辑,使得核心数据点的采集成功率稳定在XXX%以上。

3.数据清洗规整:对采集到的原始数据进行初步清洗,包括去除重复值、修正异常格式、统一字段命名;建立标准化的数据清洗流程文档,并培训新同事使用;通过流程固化,将数据预处理的平均耗时减少了XXX%。

4.采集流程优化:分析现有数据采集任务流程,发现任务调度存在资源冲突;重新设计任务队列与优先级规则,使用Airflow进行任务编排;优化后,整体采集任务的按时完成率提升了XXX%,服务器资源占用峰值下降了XXX%。

5.数据质量监测:搭建数据质量监控看板,跟踪每日采集数据的完整性、准确性和及时性;定义关键质量指标阈值,设置自动化告警;通过主动监测与排查,将数据质量问题反馈至解决的周期缩短了XXX小时。

6.采集工具维护:负责维护部门内部使用的数据采集工具集;根据业务反馈修复工具缺陷,编写用户操作指南;组织工具使用分享会,收集优化建议,使得工具平均问题解决时间缩短了XXX%。

工作业绩:

1.独立对接并引入X家新数据供应商,支撑了X个新数据产品的上线。

2.开发与维护了XXX个核心数据采集脚本,保障了每日XXX万条级数据的稳定获取。

3.主导的数据清洗流程优化,使团队月度数据处理效率提升XXX%,支持了XXX个数据项目的交付。

4.通过流程与工具优化,将整体数据采集任务的失败率降低了XXX%,资源成本节约XXX%。

5.建立的数据质量监测机制,使数据交付客户后的质量投诉率下降了XXX%。

6.维护的工具集支持了团队内X名同事的日常工作,用户满意度评分达到

X.X/5。

主动离职,希望有更多的工作挑战和涨薪机会。

项目经历

公司为某大型连锁零售客户定制的数据服务项目,客户需要实时监控主流电商平台上XXX个竞品品牌的价格、促销活动和用户评价,原有手动收集方式效率低下且滞后严重,无法满足日度决策需求。项目需建立自动化数据采集与分析流水线,处理日均XXX万级别的网页数据,并解决多平台反爬与数据结构异构的挑战。

项目职责:

1.负责爬虫架构设计:设计分布式爬虫架构,采用Scrapy-Redis框架管理爬取队列,使用Selenium处理动态渲染页面,确保对目标电商平台的全覆盖与稳定抓取。

2.协调反爬策略应对:协调资源搭建动态IP代理池和用户代理池,集成第三方打码平台应对复杂验证码,通过请求随机化策略将单个IP被封风险降低了XXX%。

3.主导数据解析模块开发:针对不同电商页面的异构结构,开发并维护一套可配置的XPath与CSS选择器规则库,编写数据解析组件,将新增页面模板的配置时间缩短了XXX%。

4.监控采集任务状态:搭建基于Prometheus和Grafana的采集任务监控面板,实时跟踪爬虫运行状态、成功率和数据流量,设置阈值告警,确保问题在XXX分钟内被察觉。

项目业绩:

1.成功构建自动化采集系统,替代了X人日的手工工作,数据获取效率提升XXX倍,实现日度数据更新。

2.系统稳定运行X个月,平均数据采集成功率维持在X

X.X%以上,有效支撑了客户每周的市场分析报告。

3.通过架构优化与资源调度,将服务器的数据采集成本较初期方案降低了XXX%。

4.项目交付后获得客户好评,直接推动了与该客户的续约,合同金额提升了XXX%。

教育背景

GPA X.XX/4.0(专业排名前XX%),主修数据库原理、数据结构与网络爬虫技术等课程,熟练掌握Python及SQL语言。参与课程设计“校园新闻聚合系统”,负责数据采集模块开发,使用Requests和BeautifulSoup库从多个新闻网站定时抓取内容,实现了日均采集并结构化存储XXX条数据。

自我评价

培训经历

系统学习了数据采集、处理、分析与建模的全流程知识。将数据质量管控的方法应用于日常采集工作,建立了关键指标监控体系,使负责项目的数据交付准确率提升至XX.X%。所总结的数据清洗SOP被团队采纳为标准流程之一。

中级数据采集整洁简历模板

适用人群: #数据采集 #中级[3-5年]

关于数据采集简历的常见问题

[基本信息]

姓名:陈小湾

性别:男

年龄:26

学历:本科

婚姻:未婚

年限:4年

面貌:党员

邮箱:xiaowan@gangwan.com

电话:18600001654

[求职意向]

工作性质:全职

应聘职位:数据采集

期望城市:北京

期望薪资:8000-10000

求职状态:离职-随时到岗

[工作经历]

北京XX科技有限公司 | 数据采集

2024-09 - 2025-12

XXX数据科技是一家专注于为金融和零售行业提供数据服务与解决方案的公司,团队规模约XXX人,核心业务是整合多渠道商业数据,为客户提供市场洞察与决策支持,服务超过XXX家机构客户,与多家数据供应商建立稳定合作。

工作概述:

1.数据源寻源:针对客户对电商评论数据的需求,主动寻找和评估潜在数据供应商;通过技术验证与商务谈判,确定数据质量与价格;主导引入X家新供应商,丰富了数据来源渠道,将单一数据源依赖度降低了XXX%。

2.爬虫脚本开发:依据数据采集需求,使用Python编写和维护定向爬虫脚本;处理目标网站的反爬策略,如验证码识别与动态IP代理池管理;优化请求频率与数据解析逻辑,使得核心数据点的采集成功率稳定在XXX%以上。

3.数据清洗规整:对采集到的原始数据进行初步清洗,包括去除重复值、修正异常格式、统一字段命名;建立标准化的数据清洗流程文档,并培训新同事使用;通过流程固化,将数据预处理的平均耗时减少了XXX%。

4.采集流程优化:分析现有数据采集任务流程,发现任务调度存在资源冲突;重新设计任务队列与优先级规则,使用Airflow进行任务编排;优化后,整体采集任务的按时完成率提升了XXX%,服务器资源占用峰值下降了XXX%。

5.数据质量监测:搭建数据质量监控看板,跟踪每日采集数据的完整性、准确性和及时性;定义关键质量指标阈值,设置自动化告警;通过主动监测与排查,将数据质量问题反馈至解决的周期缩短了XXX小时。

6.采集工具维护:负责维护部门内部使用的数据采集工具集;根据业务反馈修复工具缺陷,编写用户操作指南;组织工具使用分享会,收集优化建议,使得工具平均问题解决时间缩短了XXX%。

工作业绩:

1.独立对接并引入X家新数据供应商,支撑了X个新数据产品的上线。

2.开发与维护了XXX个核心数据采集脚本,保障了每日XXX万条级数据的稳定获取。

3.主导的数据清洗流程优化,使团队月度数据处理效率提升XXX%,支持了XXX个数据项目的交付。

4.通过流程与工具优化,将整体数据采集任务的失败率降低了XXX%,资源成本节约XXX%。

5.建立的数据质量监测机制,使数据交付客户后的质量投诉率下降了XXX%。

6.维护的工具集支持了团队内X名同事的日常工作,用户满意度评分达到

X.X/5。

[项目经历]

项目名称:零售行业竞品数据监控平台

担任角色:项目负责人

公司为某大型连锁零售客户定制的数据服务项目,客户需要实时监控主流电商平台上XXX个竞品品牌的价格、促销活动和用户评价,原有手动收集方式效率低下且滞后严重,无法满足日度决策需求。项目需建立自动化数据采集与分析流水线,处理日均XXX万级别的网页数据,并解决多平台反爬与数据结构异构的挑战。

项目业绩:

1.成功构建自动化采集系统,替代了X人日的手工工作,数据获取效率提升XXX倍,实现日度数据更新。

2.系统稳定运行X个月,平均数据采集成功率维持在X

X.X%以上,有效支撑了客户每周的市场分析报告。

3.通过架构优化与资源调度,将服务器的数据采集成本较初期方案降低了XXX%。

4.项目交付后获得客户好评,直接推动了与该客户的续约,合同金额提升了XXX%。

[教育背景]

南京理工大学

信息管理与信息系统 | 本科

GPA X.XX/4.0(专业排名前XX%),主修数据库原理、数据结构与网络爬虫技术等课程,熟练掌握Python及SQL语言。参与课程设计“校园新闻聚合系统”,负责数据采集模块开发,使用Requests和BeautifulSoup库从多个新闻网站定时抓取内容,实现了日均采集并结构化存储XXX条数据。