正在查看初级Hadoop柔和简历模板文字版

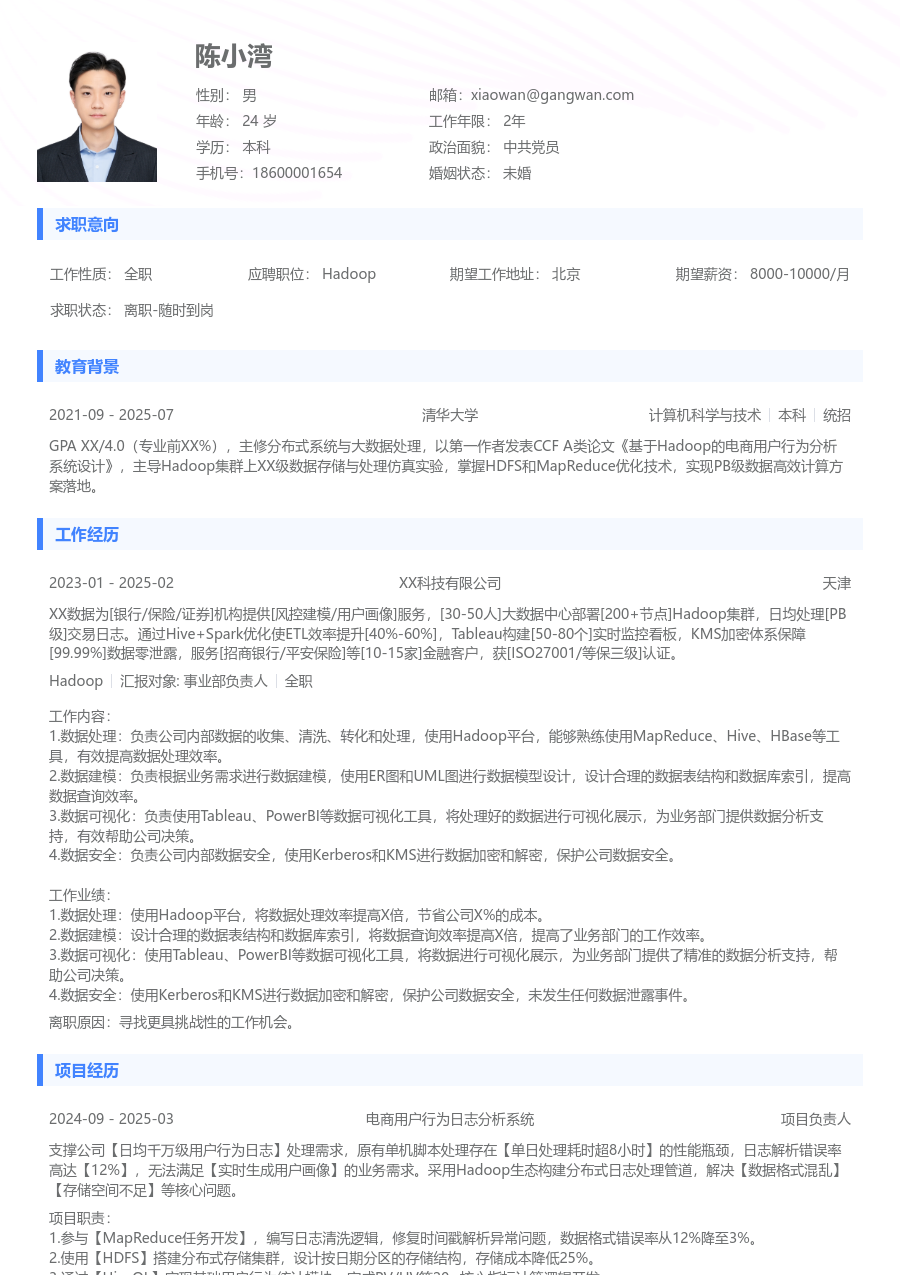

陈小湾

求职意向

工作经历

XXX科技是一家专注于物流与供应链领域大数据平台服务的公司,团队规模约XXX人,核心业务是为大型物流企业提供数据中台、智能调度与风险预警系统,产品已应用于全国超过XXX个物流枢纽,日均处理运单数据XXX万条。

工作概述:

1.数据仓库建设:为统一业务数据口径并支持跨部门分析,负责设计数据仓库的ODS、DWD分层模型;基于业务过程抽象主题域,使用Hive SQL开发核心事实表与维度表的ETL任务;配置调度依赖保障数据准时产出,并撰写数据字典便于使用者理解;通过优化大表JOIN策略与压缩格式,将核心任务链运行时间缩短XXX%,任务成功率稳定在XXX%。

2.实时计算开发:为满足物流轨迹实时监控的业务需求,参与构建基于Flink的流式计算管道;负责开发从Kafka消费GPS报文数据的实时作业,进行数据解析、去噪和窗口聚合;将处理后的实时结果写入ClickHouse供前端大屏展示;通过调整并行度与状态后端配置,将作业的端到端延迟降低至XXX秒内,峰值吞吐量达到每秒XXX条。

3.集群管理:承担大数据平台部分集群的日常运维职责,制定巡检清单监控HDFS存储水位、YARN队列资源使用率及服务健康状态;执行集群组件的版本升级与补丁安装,提前在测试环境完成验证并编写操作手册;处理线上任务失败告警,分析日志定位常见原因;通过优化HDFS副本策略与清理过期数据,累计释放存储空间XXX TB,平台月度整体可用性达XXX%。

4.性能调优:针对即席查询与报表任务慢的问题,分析Hive/Spark执行计划定位瓶颈;对高频访问的表增加分区、分桶并收集统计信息;优化YARN资源队列配置,为关键任务分配保障性资源;推动将部分复杂逻辑的Hive SQL重写为Spark程序;上述措施使平均查询响应时间减少XXX%,计算资源消耗降低约XXX%。

5.数据治理:参与公司数据治理专项,为提升数据质量与可追溯性,协助制定数据标准与命名规范;开发数据质量稽核脚本,定期检查核心表的记录数波动、主键唯一性与字段填充率,并发送报告;梳理关键数据链路血缘,为XXX张重要数据资产打标;通过治理,核心业务数据的一致率从XX%提升至XXX%,下游数据投诉减少XXX%。

6.运维工具开发:为提高运维效率与减少人为失误,开发一系列自动化运维脚本;编写Python脚本自动收集集群指标并生成日报,开发Shell脚本一键完成日志清理与备份;将常用诊断命令封装为简易WEB工具供团队使用;工具推广后,日常巡检与数据清理操作耗时平均减少XXX%,相关人为操作错误降为0。

工作业绩:

1.主导完成了X个主题域的数据仓库建设,涉及XXX余张核心表,支撑了公司经营分析、运营监控等X个数据应用场景。

2.开发的实时计算作业稳定运行超XXX天,日均处理数据量XXX亿条,有力支持了物流实时追踪与异常预警业务上线。

3.负责运维的集群规模达XXX个节点,存储量XXX PB,通过有效管理保障了全年核心数据任务无重大故障。

4.累计完成XXX项性能优化,使整体平台资源利用率提升XXX%,季度计算成本预估节约XXX%。

5.参与的数据治理项目覆盖XXX项核心数据指标,数据质量告警数季度环比下降XXX%。

6.开发的X个运维工具被团队采纳为标准操作流程,平均每月节省团队运维工时约XXX人时。

主动离职,希望有更多的工作挑战和涨薪机会。

项目经历

公司为某头部物流企业打造的核心风控项目,原有系统基于T+1模式对运单进行风险扫描,无法及时发现运输途中的异常行为(如路线偏离、长时间滞留)。项目需构建毫秒级响应的实时风控引擎,对接全量GPS流数据与运单主数据,日均处理数据量XXX亿条,识别准确率要求高于XXX%。

项目职责:

1.实时处理开发:负责风控规则实时计算模块的开发,使用Flink DataStream API消费Kafka中的GPS数据流,与Redis中缓存的运单信息进行实时关联,实现基于时间与地理围窗的复杂规则计算。

2.性能优化:针对实时作业状态数据膨胀导致Checkpoint缓慢的问题,优化状态后端配置并使用增量Checkpoint机制,将作业恢复时间从分钟级缩短至秒级,保障了服务SLA。

3.数据整合:设计并开发实时结果数据与离线批处理结果的融合链路,将实时风险标签与离线深度分析标签在Hive中关联,产出完整的风险画像宽表。

4.质量保障:编写实时数据对账脚本,比对源头数据量与处理后写入下游的数据量,确保数据处理链路的数据一致性;参与制定压测方案,验证系统在高并发下的稳定性。

项目业绩:

1.系统成功上线,实现从GPS事件产生到风险告警输出的端到端延迟稳定在XXX毫秒以内。

2.实时风控引擎日均处理数据XXX亿条,峰值QPS达到XXX,准确识别异常运单XXX万条/月。

3.通过状态优化,作业的Checkpoint成功率达到XXX%,系统可用性超过XXX%。

4.项目帮助客户将运输途中重大异常事件的发现时间从平均X小时缩短至X分钟内,获得客户好评。

教育背景

GPA X.XX/X.X(专业前XX%),主修数据结构、操作系统、数据库原理及分布式计算课程。熟练掌握Hadoop生态(HDFS, YARN, Hive, Spark)及Java/Scala开发,参与课程设计《电商用户行为分析系统》,负责搭建基于Hive的数据仓库并进行用户购买漏斗分析,使用Azkaban进行任务调度,项目获得优秀评价。

自我评价

培训经历

系统掌握了CDH集群的规划、部署、管理和性能调优。将认证中的最佳实践应用于生产环境,优化了集群资源配置与作业调度策略,提升了平台整体运行效率与稳定性。

初级Hadoop柔和简历模板

适用人群: #Hadoop #初级[1-3年]

猜你想用

关于Hadoop简历的常见问题

[基本信息]

姓名:陈小湾

性别:男

年龄:26

学历:本科

婚姻:未婚

年限:4年

面貌:党员

邮箱:xiaowan@gangwan.com

电话:18600001654

[求职意向]

工作性质:全职

应聘职位:Hadoop

期望城市:北京

期望薪资:8000-10000

求职状态:离职-随时到岗

[工作经历]

北京XX科技有限公司 | Hadoop

2024-09 - 2025-12

XXX科技是一家专注于物流与供应链领域大数据平台服务的公司,团队规模约XXX人,核心业务是为大型物流企业提供数据中台、智能调度与风险预警系统,产品已应用于全国超过XXX个物流枢纽,日均处理运单数据XXX万条。

工作概述:

1.数据仓库建设:为统一业务数据口径并支持跨部门分析,负责设计数据仓库的ODS、DWD分层模型;基于业务过程抽象主题域,使用Hive SQL开发核心事实表与维度表的ETL任务;配置调度依赖保障数据准时产出,并撰写数据字典便于使用者理解;通过优化大表JOIN策略与压缩格式,将核心任务链运行时间缩短XXX%,任务成功率稳定在XXX%。

2.实时计算开发:为满足物流轨迹实时监控的业务需求,参与构建基于Flink的流式计算管道;负责开发从Kafka消费GPS报文数据的实时作业,进行数据解析、去噪和窗口聚合;将处理后的实时结果写入ClickHouse供前端大屏展示;通过调整并行度与状态后端配置,将作业的端到端延迟降低至XXX秒内,峰值吞吐量达到每秒XXX条。

3.集群管理:承担大数据平台部分集群的日常运维职责,制定巡检清单监控HDFS存储水位、YARN队列资源使用率及服务健康状态;执行集群组件的版本升级与补丁安装,提前在测试环境完成验证并编写操作手册;处理线上任务失败告警,分析日志定位常见原因;通过优化HDFS副本策略与清理过期数据,累计释放存储空间XXX TB,平台月度整体可用性达XXX%。

4.性能调优:针对即席查询与报表任务慢的问题,分析Hive/Spark执行计划定位瓶颈;对高频访问的表增加分区、分桶并收集统计信息;优化YARN资源队列配置,为关键任务分配保障性资源;推动将部分复杂逻辑的Hive SQL重写为Spark程序;上述措施使平均查询响应时间减少XXX%,计算资源消耗降低约XXX%。

5.数据治理:参与公司数据治理专项,为提升数据质量与可追溯性,协助制定数据标准与命名规范;开发数据质量稽核脚本,定期检查核心表的记录数波动、主键唯一性与字段填充率,并发送报告;梳理关键数据链路血缘,为XXX张重要数据资产打标;通过治理,核心业务数据的一致率从XX%提升至XXX%,下游数据投诉减少XXX%。

6.运维工具开发:为提高运维效率与减少人为失误,开发一系列自动化运维脚本;编写Python脚本自动收集集群指标并生成日报,开发Shell脚本一键完成日志清理与备份;将常用诊断命令封装为简易WEB工具供团队使用;工具推广后,日常巡检与数据清理操作耗时平均减少XXX%,相关人为操作错误降为0。

工作业绩:

1.主导完成了X个主题域的数据仓库建设,涉及XXX余张核心表,支撑了公司经营分析、运营监控等X个数据应用场景。

2.开发的实时计算作业稳定运行超XXX天,日均处理数据量XXX亿条,有力支持了物流实时追踪与异常预警业务上线。

3.负责运维的集群规模达XXX个节点,存储量XXX PB,通过有效管理保障了全年核心数据任务无重大故障。

4.累计完成XXX项性能优化,使整体平台资源利用率提升XXX%,季度计算成本预估节约XXX%。

5.参与的数据治理项目覆盖XXX项核心数据指标,数据质量告警数季度环比下降XXX%。

6.开发的X个运维工具被团队采纳为标准操作流程,平均每月节省团队运维工时约XXX人时。

[项目经历]

项目名称:物流实时风控与预警系统

担任角色:项目负责人

公司为某头部物流企业打造的核心风控项目,原有系统基于T+1模式对运单进行风险扫描,无法及时发现运输途中的异常行为(如路线偏离、长时间滞留)。项目需构建毫秒级响应的实时风控引擎,对接全量GPS流数据与运单主数据,日均处理数据量XXX亿条,识别准确率要求高于XXX%。

项目业绩:

1.系统成功上线,实现从GPS事件产生到风险告警输出的端到端延迟稳定在XXX毫秒以内。

2.实时风控引擎日均处理数据XXX亿条,峰值QPS达到XXX,准确识别异常运单XXX万条/月。

3.通过状态优化,作业的Checkpoint成功率达到XXX%,系统可用性超过XXX%。

4.项目帮助客户将运输途中重大异常事件的发现时间从平均X小时缩短至X分钟内,获得客户好评。

[教育背景]

河北工业大学

计算机科学与技术 | 本科

GPA X.XX/X.X(专业前XX%),主修数据结构、操作系统、数据库原理及分布式计算课程。熟练掌握Hadoop生态(HDFS, YARN, Hive, Spark)及Java/Scala开发,参与课程设计《电商用户行为分析系统》,负责搭建基于Hive的数据仓库并进行用户购买漏斗分析,使用Azkaban进行任务调度,项目获得优秀评价。