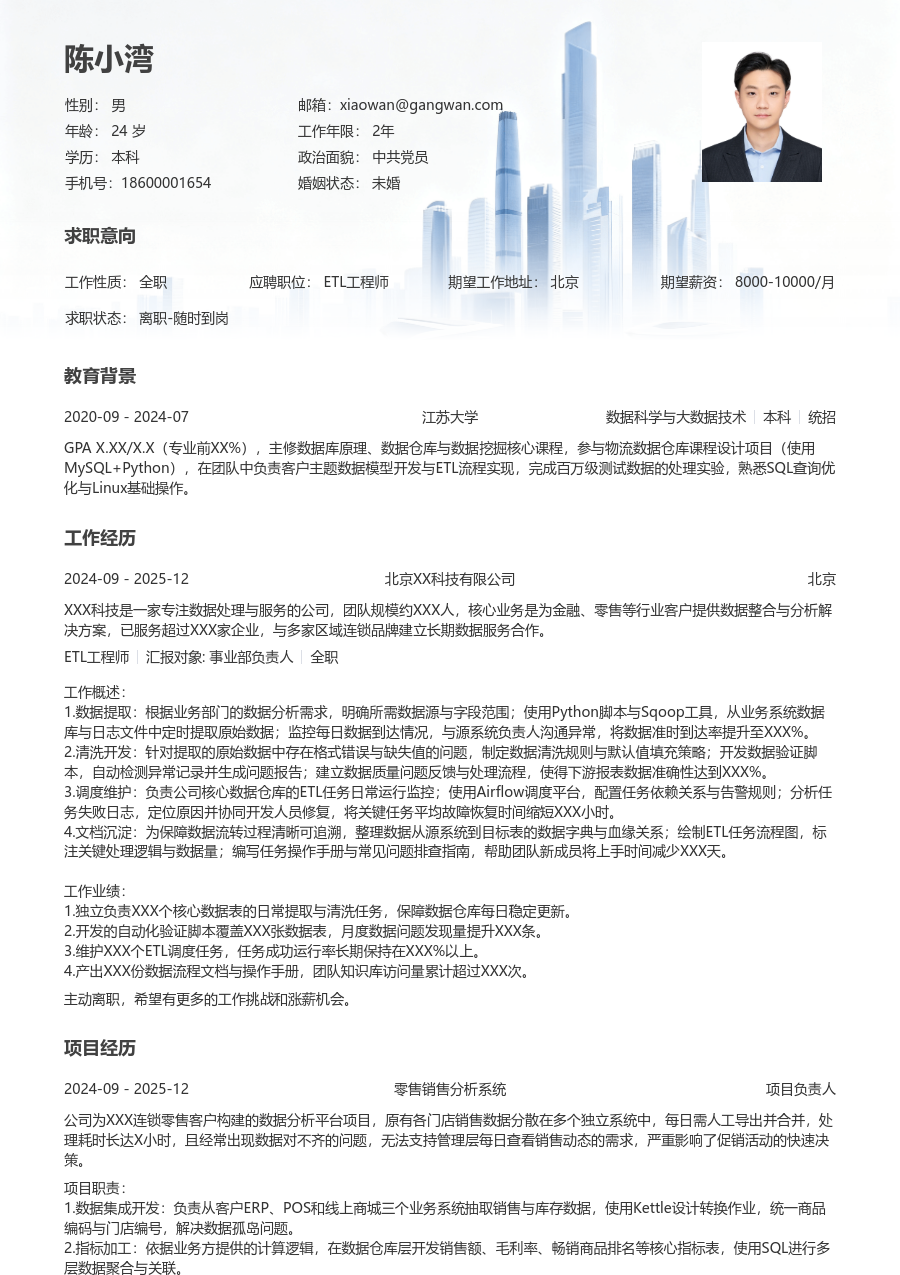

正在查看初级ETL工程师规范简历模板文字版

陈小湾

求职意向

工作经历

XXX科技是一家专注于为零售和金融行业提供数据服务与解决方案的公司,团队规模约XXX人,核心业务包括数据平台搭建、商业智能分析和数据治理咨询,已为超过XXX家中型企业提供数据服务,并与多家区域性银行建立了稳定的合作关系。

工作概述:

1.数据同步:负责将业务系统的订单和用户数据同步至数据仓库,与业务部门沟通确定数据范围和更新频率;使用Sqoop和DataX工具编写同步脚本,并配置定时任务;监控同步任务运行状态,处理因网络或源系统变更导致的失败,将数据同步任务的成功率稳定在XXX%以上。

2.数据建模:根据分析需求参与数据仓库模型设计,理解业务指标口径;使用维度建模方法,在Hive中创建和维护事实表与维度表;编写SQL处理缓慢变化维,确保历史数据可追溯,支撑了XXX个核心报表的数据需求。

3.任务优化:针对运行缓慢的ETL任务进行分析,定位SQL代码或资源配置问题;通过优化Join条件、增加分区索引和调整计算资源分配,将关键数据加工任务的运行时间平均缩短了XXX%。

4.脚本开发:开发Python和Shell脚本,用于自动化处理数据文件的上传、校验和异常报警;脚本封装了与FTP服务器和对象存储的交互,减少了人工干预,每周节省约XXX人时的运维工作量。

5.数据监控:搭建基础的数据质量监控体系,在关键ETL环节设置数据量、唯一性和准确性校验规则;每日检查监控报告,对异常数据进行探查并通知相关人员,将下游报表数据问题的发现时间平均提前了XXX小时。

6.文档沉淀:维护ETL任务文档和数据字典,记录表结构、清洗规则和血缘关系;在团队内部分享常见问题的排查方法,帮助新人快速上手,将同类问题咨询量减少了XXX%。

工作业绩:

1.独立负责XXX个数据同步管道的开发与运维,保障了每日TB级数据稳定入仓。

2.参与构建了涵盖XXX个主题域的数据仓库模型,支撑了销售、运营等XXX个部门的分析需求。

3.累计优化了XXX个长时运行ETL任务,整体夜间批处理窗口缩短了XXX小时。

4.开发的自动化脚本处理了超过XXX万份数据文件,准确率达到XXX%。

5.建立的数据监控规则覆盖XXX张核心表,有效拦截了XXX次数据质量问题。

6.编写和维护了XXX份技术文档,成为团队的标准参考资料。

主动离职,希望有更多的工作挑战和涨薪机会。

项目经历

公司为一家连锁零售商搭建的数据平台项目,原有数据仓库基于传统关系数据库,无法支撑每日新增XXX GB业务数据的处理需求,ETL流程串行执行导致数据产出经常延迟X小时以上,在促销季无法满足管理层对销售数据的实时洞察需求,同时数据加工逻辑分散在多个脚本中,维护成本高且出错频繁。

项目职责:

1.功能开发:负责将部分核心业务模块(如商品和会员)的数据加工逻辑迁移至Hadoop平台,使用Hive SQL重写数据清洗和聚合代码,并配置Oozie工作流进行任务调度。

2.性能优化:分析迁移后任务性能瓶颈,对涉及大数据表关联的SQL进行优化,通过启用Map端Join、重构子查询等方式,将关键任务执行时间降低XXX%。

3.流程优化:参与设计新的分层ETL架构,将原有的单层加工拆分为ODS、DWD、DWS层,明确各层职责,使得数据处理流程更清晰,降低了任务间的耦合度。

4.质量保障:为迁移后的核心表编写数据一致性对比脚本,确保新老平台数据结果一致;在关键节点增加数据质量检查点,保障数据输出准确。

项目业绩:

1.成功迁移并优化了XXX个核心ETL任务,整体夜间批处理时间从X小时降至Y小时,保障了数据在每日上午X点前准时产出。

2.新架构下数据处理逻辑清晰化,任务失败率下降XXX%,运维排查效率提升XXX%。

3.项目支撑了XXX家门店的销售数据分析,助力客户在促销季实现销售额提升XXX%。

教育背景

GPA X.XX/4.0(专业前XX%),主修数据库原理、数据仓库与数据挖掘等课程,熟练掌握SQL和Python。课程设计中独立完成一个电商用户行为分析模块的ETL流程开发,使用MySQL和Python进行数据抽取、清洗与汇总,形成数据分析报告。

自我评价

培训经历

系统学习了阿里云MaxCompute、DataWorks等大数据平台组件架构与开发技术。将培训所学的任务优化与资源调度方法应用于实际工作,通过调整SQL写法与合理设置任务参数,使得负责的ETL任务资源消耗平均下降XXX%,运行稳定性得到提高。

初级ETL工程师规范简历模板

适用人群: #ETL工程师 #初级[1-3年]

关于ETL工程师简历的常见问题

[基本信息]

姓名:陈小湾

性别:男

年龄:26

学历:本科

婚姻:未婚

年限:4年

面貌:党员

邮箱:xiaowan@gangwan.com

电话:18600001654

[求职意向]

工作性质:全职

应聘职位:ETL工程师

期望城市:北京

期望薪资:8000-10000

求职状态:离职-随时到岗

[工作经历]

北京XX科技有限公司 | ETL工程师

2024-09 - 2025-12

XXX科技是一家专注于为零售和金融行业提供数据服务与解决方案的公司,团队规模约XXX人,核心业务包括数据平台搭建、商业智能分析和数据治理咨询,已为超过XXX家中型企业提供数据服务,并与多家区域性银行建立了稳定的合作关系。

工作概述:

1.数据同步:负责将业务系统的订单和用户数据同步至数据仓库,与业务部门沟通确定数据范围和更新频率;使用Sqoop和DataX工具编写同步脚本,并配置定时任务;监控同步任务运行状态,处理因网络或源系统变更导致的失败,将数据同步任务的成功率稳定在XXX%以上。

2.数据建模:根据分析需求参与数据仓库模型设计,理解业务指标口径;使用维度建模方法,在Hive中创建和维护事实表与维度表;编写SQL处理缓慢变化维,确保历史数据可追溯,支撑了XXX个核心报表的数据需求。

3.任务优化:针对运行缓慢的ETL任务进行分析,定位SQL代码或资源配置问题;通过优化Join条件、增加分区索引和调整计算资源分配,将关键数据加工任务的运行时间平均缩短了XXX%。

4.脚本开发:开发Python和Shell脚本,用于自动化处理数据文件的上传、校验和异常报警;脚本封装了与FTP服务器和对象存储的交互,减少了人工干预,每周节省约XXX人时的运维工作量。

5.数据监控:搭建基础的数据质量监控体系,在关键ETL环节设置数据量、唯一性和准确性校验规则;每日检查监控报告,对异常数据进行探查并通知相关人员,将下游报表数据问题的发现时间平均提前了XXX小时。

6.文档沉淀:维护ETL任务文档和数据字典,记录表结构、清洗规则和血缘关系;在团队内部分享常见问题的排查方法,帮助新人快速上手,将同类问题咨询量减少了XXX%。

工作业绩:

1.独立负责XXX个数据同步管道的开发与运维,保障了每日TB级数据稳定入仓。

2.参与构建了涵盖XXX个主题域的数据仓库模型,支撑了销售、运营等XXX个部门的分析需求。

3.累计优化了XXX个长时运行ETL任务,整体夜间批处理窗口缩短了XXX小时。

4.开发的自动化脚本处理了超过XXX万份数据文件,准确率达到XXX%。

5.建立的数据监控规则覆盖XXX张核心表,有效拦截了XXX次数据质量问题。

6.编写和维护了XXX份技术文档,成为团队的标准参考资料。

[项目经历]

项目名称:零售企业离线数据仓库优化

担任角色:项目负责人

公司为一家连锁零售商搭建的数据平台项目,原有数据仓库基于传统关系数据库,无法支撑每日新增XXX GB业务数据的处理需求,ETL流程串行执行导致数据产出经常延迟X小时以上,在促销季无法满足管理层对销售数据的实时洞察需求,同时数据加工逻辑分散在多个脚本中,维护成本高且出错频繁。

项目业绩:

1.成功迁移并优化了XXX个核心ETL任务,整体夜间批处理时间从X小时降至Y小时,保障了数据在每日上午X点前准时产出。

2.新架构下数据处理逻辑清晰化,任务失败率下降XXX%,运维排查效率提升XXX%。

3.项目支撑了XXX家门店的销售数据分析,助力客户在促销季实现销售额提升XXX%。

[教育背景]

昆明理工大学

软件工程 | 本科

GPA X.XX/4.0(专业前XX%),主修数据库原理、数据仓库与数据挖掘等课程,熟练掌握SQL和Python。课程设计中独立完成一个电商用户行为分析模块的ETL流程开发,使用MySQL和Python进行数据抽取、清洗与汇总,形成数据分析报告。