正在查看高级ETL工程师未来简历模板文字版

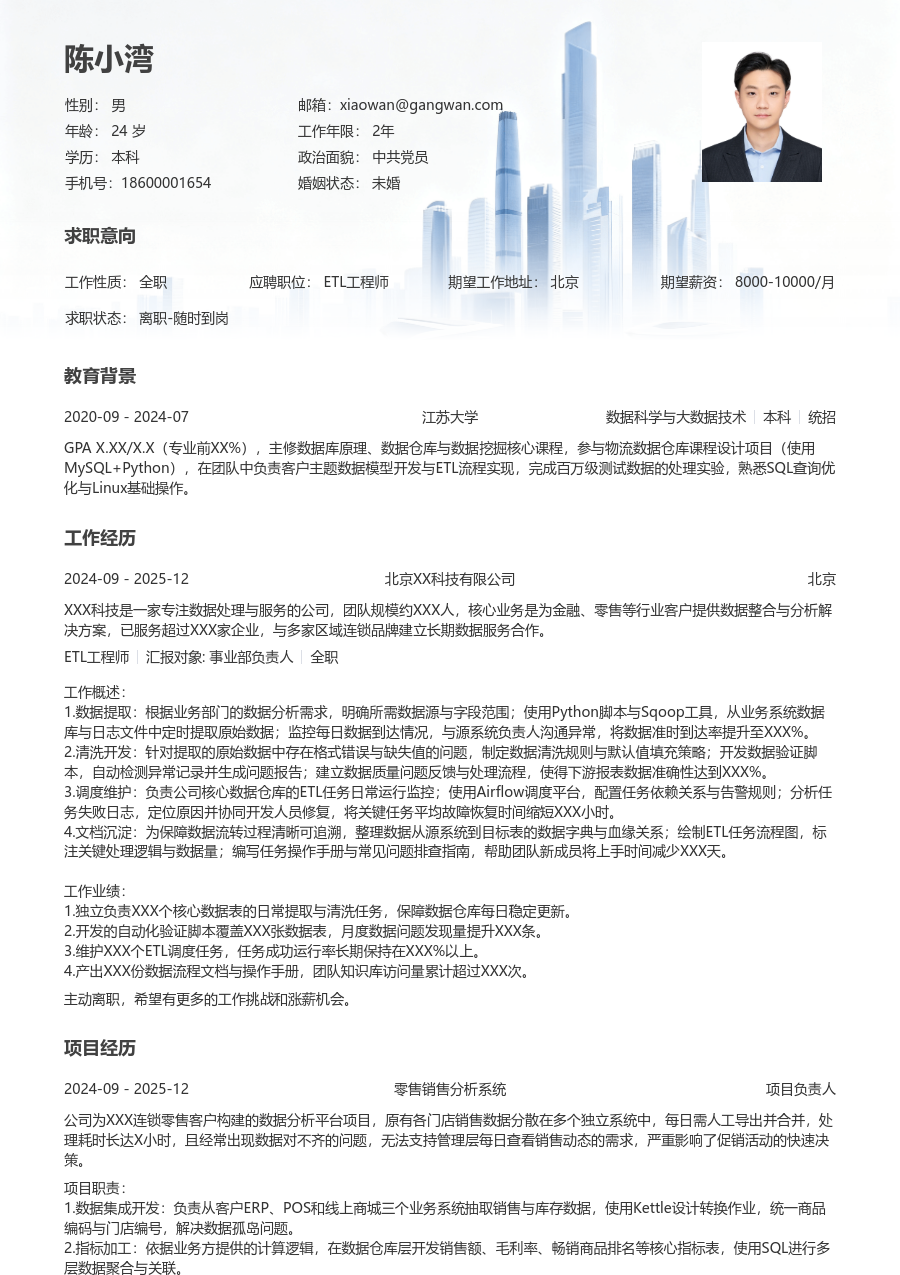

陈小湾

求职意向

工作经历

XXX科技是专注金融信贷风控领域的科技公司,团队规模约XXX人,核心业务是为银行与消费金融公司提供智能风控与数据分析解决方案,产品服务于超过XXX家机构,日均处理信贷申请数据XXX万条。

工作概述:

1.数据架构设计:为支持信贷审批与风险报告业务,设计并搭建数仓分层架构;调研并引入DataX替代老旧脚本工具,规范ODS-DWD-DWS-ADS模型层;主导制定数据建模与开发规范文档,经推广后使团队任务失败率降低XXX%。

2.数据集成开发:负责从多个业务系统(核心交易、客户管理、外部征信)进行数据抽取与清洗;编写和维护Hive SQL与Spark脚本处理每日增量与全量数据;建立数据血缘与影响分析地图,保障数据一致性,将数据按时产出率提升至XXX%。

3.任务调度管理:使用DolphinScheduler统一管理XXX个以上日常ETL任务;设计任务依赖与告警策略,快速定位并解决任务失败与延迟问题;通过资源队列隔离与任务优先级调整,将关键报表任务的产出时间提前X小时。

4.数据质量监控:针对关键风控指标数据建立质量稽核规则;开发质量监控看板,每日自动检查数据完整性、准确性与及时性;推动问题数据回溯与修复流程上线,将数据问题发现至解决的平均周期缩短XXX%。

5.性能优化:分析慢速SQL与任务,通过优化Hive表分区策略、增加索引与调整Spark参数进行调优;重构部分复杂计算逻辑,将单次跑批任务的平均执行时间减少XXX%,月度计算资源成本节省XXX元。

6.技术规范制定:编写《数据开发入门手册》与《SQL编码规范》,作为新人入职培训资料;在团队内组织技术分享会,推广使用Git进行代码版本管理,使代码评审通过效率提升XXX%。

7.团队协作指导:协助项目经理进行任务拆解与排期;指导X名初级工程师完成数据模块开发与问题排查;通过代码Review传递最佳实践,所指导成员独立负责的任务占比在半年内提升至XXX%。

工作业绩:

1.主导设计并落地信贷主题数据仓库,支撑风险报告、用户画像等X个核心数据应用稳定运行X年。

2.独立开发与维护XXX个以上ETL任务脚本,保障每日XXXTB级数据按时、准确产出。

3.通过调度优化与性能调优,将整体ETL任务链路的SLA从XX%提升至X

X.X%。

4.建立的数据质量监控体系覆盖XXX张核心表,拦截并修复数据质量问题XXX余个。

5.输出的技术规范文档被团队采纳,帮助新成员上手周期平均缩短X天。

6.指导团队成员完成的信贷审批宽表开发,直接支持上线X个风控模型,模型效果提升X%。

主动离职,希望有更多的工作挑战和涨薪机会。

项目经历

公司核心的信贷风控数据支撑项目,原有数据分散在多个独立MySQL与Oracle库中,形成数据孤岛,无法满足实时审批与多头共债分析需求;T+1的批量处理模式导致关键风控指标更新延迟高达X小时,数据质量缺乏监控,历史数据追溯困难,在业务高峰期经常因数据处理延迟影响审批决策。

项目职责:

1.平台架构搭建:负责数据中台底层架构技术选型与搭建,基于Hadoop+Hive构建离线数仓,采用Kafka+Flink构建实时数据流;设计分层数据模型,统一来自X个业务系统的数据口径。

2.核心模块开发:主导审批流水、客户信息、征信报告等核心主题域的ETL开发;负责实时数据管道开发,将关键风控事件的处理延时从分钟级降低至秒级。

3.数据质量体系:设计并实施全链路数据质量监控方案,为XXX个关键指标配置稽核规则;建立数据问题工单流转流程,确保问题可跟踪、可闭环。

4.性能优化与运维:解决Flink作业状态过大导致的恢复慢问题;优化Hive大表关联逻辑,将夜间核心批处理任务运行时间缩短XXX%。

项目业绩:

1.建成统一信贷数据中台,整合X个系统数据,支撑实时审批、每日风险报表等X个上层应用,日处理数据量达XXX亿条。

2.实现关键风控指标的实时计算与推送,将数据服务时效从T+1提升至准实时,助力审批自动化率提升XXX%。

3.数据质量监控规则覆盖率达XXX%,主动发现并修复数据异常XXX次,数据问题导致的业务投诉下降XXX%。

4.项目成功支撑公司信贷产品日审批量从XXX万笔提升至XXX万笔,期间数据平台保持零重大故障。

教育背景

GPA X.XX/4.0(专业前XX%),主修数据库原理、数据仓库与数据挖掘等核心课程,熟练掌握Python与SQL语言。参与课程设计项目《电商用户行为日志分析系统》,负责使用Scala编写Spark作业进行数据清洗与聚合分析,实现日均百万级日志数据的处理,熟悉Linux系统基础操作与Shell脚本编写。

自我评价

培训经历

系统学习了数据治理框架与方法论,并将数据资产盘点、数据质量评估等核心方法应用于信贷数据中台项目。依据认证知识,主导制定了项目的数据质量评估标准与核心数据资产目录,推动业务部门对XXX个关键数据项的定义达成一致,使得数据质量规则制定效率提升XXX%,数据需求沟通成本降低XXX%。

高级ETL工程师未来简历模板

适用人群: #ETL工程师 #高级[5-10年]

关于ETL工程师简历的常见问题

[基本信息]

姓名:陈小湾

性别:男

年龄:26

学历:本科

婚姻:未婚

年限:4年

面貌:党员

邮箱:xiaowan@gangwan.com

电话:18600001654

[求职意向]

工作性质:全职

应聘职位:ETL工程师

期望城市:北京

期望薪资:8000-10000

求职状态:离职-随时到岗

[工作经历]

北京XX科技有限公司 | ETL工程师

2024-09 - 2025-12

XXX科技是专注金融信贷风控领域的科技公司,团队规模约XXX人,核心业务是为银行与消费金融公司提供智能风控与数据分析解决方案,产品服务于超过XXX家机构,日均处理信贷申请数据XXX万条。

工作概述:

1.数据架构设计:为支持信贷审批与风险报告业务,设计并搭建数仓分层架构;调研并引入DataX替代老旧脚本工具,规范ODS-DWD-DWS-ADS模型层;主导制定数据建模与开发规范文档,经推广后使团队任务失败率降低XXX%。

2.数据集成开发:负责从多个业务系统(核心交易、客户管理、外部征信)进行数据抽取与清洗;编写和维护Hive SQL与Spark脚本处理每日增量与全量数据;建立数据血缘与影响分析地图,保障数据一致性,将数据按时产出率提升至XXX%。

3.任务调度管理:使用DolphinScheduler统一管理XXX个以上日常ETL任务;设计任务依赖与告警策略,快速定位并解决任务失败与延迟问题;通过资源队列隔离与任务优先级调整,将关键报表任务的产出时间提前X小时。

4.数据质量监控:针对关键风控指标数据建立质量稽核规则;开发质量监控看板,每日自动检查数据完整性、准确性与及时性;推动问题数据回溯与修复流程上线,将数据问题发现至解决的平均周期缩短XXX%。

5.性能优化:分析慢速SQL与任务,通过优化Hive表分区策略、增加索引与调整Spark参数进行调优;重构部分复杂计算逻辑,将单次跑批任务的平均执行时间减少XXX%,月度计算资源成本节省XXX元。

6.技术规范制定:编写《数据开发入门手册》与《SQL编码规范》,作为新人入职培训资料;在团队内组织技术分享会,推广使用Git进行代码版本管理,使代码评审通过效率提升XXX%。

7.团队协作指导:协助项目经理进行任务拆解与排期;指导X名初级工程师完成数据模块开发与问题排查;通过代码Review传递最佳实践,所指导成员独立负责的任务占比在半年内提升至XXX%。

工作业绩:

1.主导设计并落地信贷主题数据仓库,支撑风险报告、用户画像等X个核心数据应用稳定运行X年。

2.独立开发与维护XXX个以上ETL任务脚本,保障每日XXXTB级数据按时、准确产出。

3.通过调度优化与性能调优,将整体ETL任务链路的SLA从XX%提升至X

X.X%。

4.建立的数据质量监控体系覆盖XXX张核心表,拦截并修复数据质量问题XXX余个。

5.输出的技术规范文档被团队采纳,帮助新成员上手周期平均缩短X天。

6.指导团队成员完成的信贷审批宽表开发,直接支持上线X个风控模型,模型效果提升X%。

[项目经历]

项目名称:信贷审批数据中台

担任角色:项目负责人

公司核心的信贷风控数据支撑项目,原有数据分散在多个独立MySQL与Oracle库中,形成数据孤岛,无法满足实时审批与多头共债分析需求;T+1的批量处理模式导致关键风控指标更新延迟高达X小时,数据质量缺乏监控,历史数据追溯困难,在业务高峰期经常因数据处理延迟影响审批决策。

项目业绩:

1.建成统一信贷数据中台,整合X个系统数据,支撑实时审批、每日风险报表等X个上层应用,日处理数据量达XXX亿条。

2.实现关键风控指标的实时计算与推送,将数据服务时效从T+1提升至准实时,助力审批自动化率提升XXX%。

3.数据质量监控规则覆盖率达XXX%,主动发现并修复数据异常XXX次,数据问题导致的业务投诉下降XXX%。

4.项目成功支撑公司信贷产品日审批量从XXX万笔提升至XXX万笔,期间数据平台保持零重大故障。

[教育背景]

河北工业大学

计算机科学与技术 | 本科

GPA X.XX/4.0(专业前XX%),主修数据库原理、数据仓库与数据挖掘等核心课程,熟练掌握Python与SQL语言。参与课程设计项目《电商用户行为日志分析系统》,负责使用Scala编写Spark作业进行数据清洗与聚合分析,实现日均百万级日志数据的处理,熟悉Linux系统基础操作与Shell脚本编写。